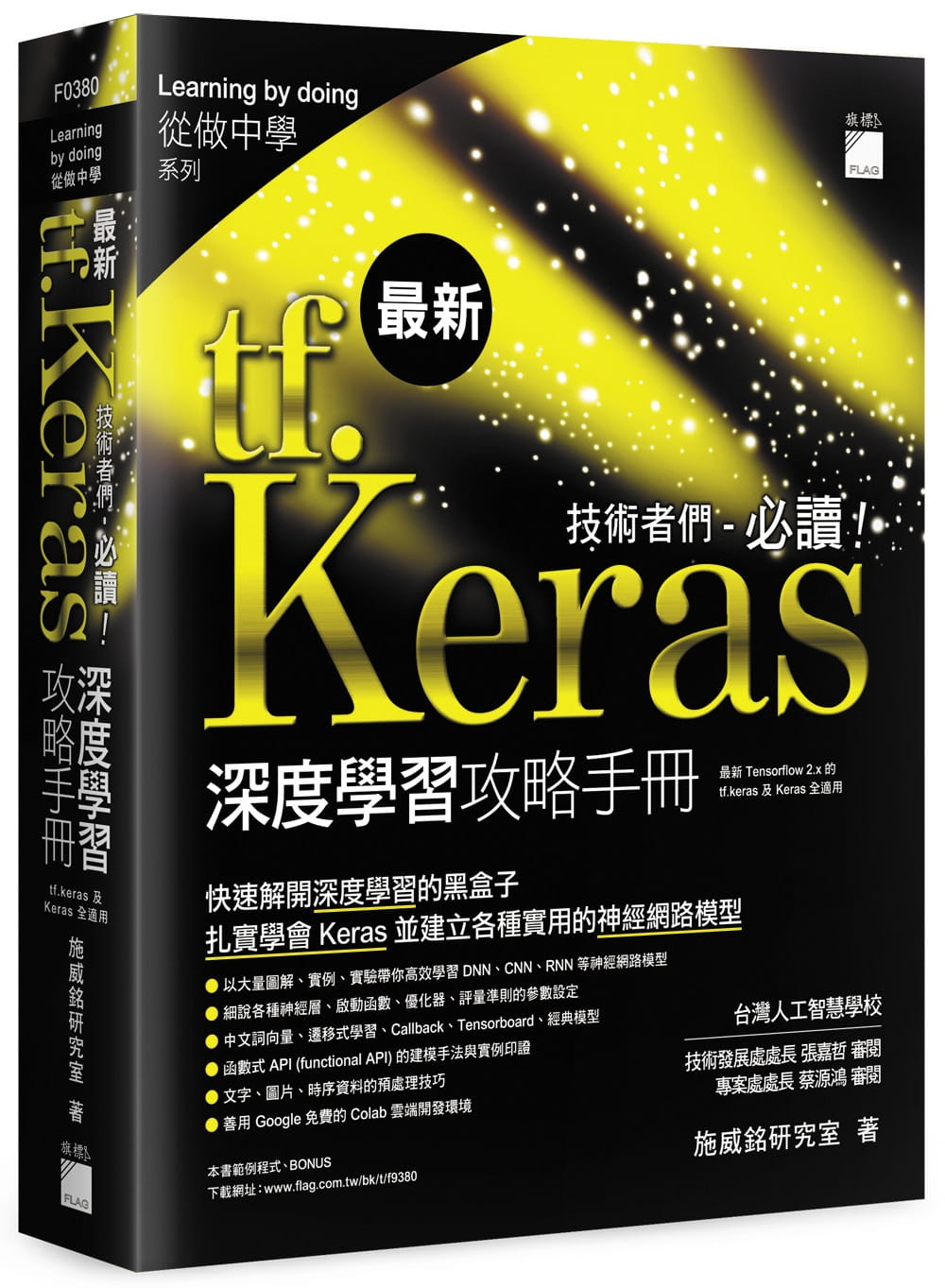

剛接觸 Deep learning 深度學習, 大家都說 Keras 實作最簡單、最多人用, 各種參考資源也很豐富, 但實際學習 Keras 卻一直卡關...

?

.官方網站資源豐富, 但不知從何查起?一大堆參數說明夾雜各種專有名詞, 有看沒有懂?

.跟著書上或網路上的範例實作都做得出來, 不過卻不知道為什麼要這麼做?

.用經典 MNIST 資料集辨識手寫數字, 準確率都 97 趴以上, 換成自己寫的數字就掉到 5、60 趴?

.神經網路的程式常出現 NumPy 的陣列運算, 還有什麼矩陣點積、轉置、陣列擴張, 搞不懂是怎麼算出來的?

.損失函數、優化器、評量準則(metrics)的種類那麼多, 在實作各種神經網路時, 到底該如何選擇和搭配呢?

.文字資料的處理都只用英文資料集來訓練, 中文資料又該怎麼訓練咧?

.聽說 Colab 雲端開發環境很好用, 但資料檔、圖檔、模組等要如何上傳呢?可以連結到我的雲端硬碟嗎?

.…

?

Deep learning 深度學習涉及的知識面向廣泛, 要有數學基礎、統計概念, 還要有資料處理的基本觀念, 最重要是要具備一定程度的 Python 功力, 才有能力跟著實作。如果不是在這個領域打滾好幾年的老手, 大概很難面面俱到。加上神經網路的內部結構是超乎想像的複雜, 玄之又玄的輸出結果, 讓許多人把深度學習當作參不透的黑盒子或煉金術, 反正跟著高手、神人套用現成的模型架構來訓練就對了。

?

事實上, AI 不僅是工程設計, 更是實證科學, 必須多方嚴謹的測試與印證, 才能打好基礎!千萬不要下載一個模型、跑跑測試集就認為學會 AI 了…。而本書的使命, 就是要為您揭開深度學習的黑盒子, 用追根究底的實驗精神, 帶您扎實學會 Keras 並建立各種實用的神經網路模型, 別人說不清楚的事, 就由我們來幫您逐一解惑, 並帶您順利地學會、學通 Keras 及深度學習!?

?

本書特色

?

台灣人工智慧學校?

---------------------------------

技術發展處處長 張嘉哲 審閱

專案處處長 蔡源鴻 審閱

?

○ 解開黑盒子 – 高效學習 DNN、CNN、RNN 等神經網路模型

○ 發揮追根究柢的實驗精神, 測試各種神經網路模型「配方」

○ 隨時幫你複習進階的 Python 程式語法及函式用法, 學習不卡關!

○ 完整介紹文字、圖片、時序資料的預處理技巧

○ 函數式 API (functional API) 的建模手法與實例印證

○ 中文詞向量、遷移式學習、Callback、Tensorboard

○ LeNet、AlexNet、VGG、GoogLeNet、ResNet、DenseNet.. 等 CNN 經典模型的進化秘方

○ 在雲端高速訓練模型 - 善用 Google 免費的 Colab 雲端開發環境

?

Keras 是目前深度學習領域中, 最容易使用且功能強大的神經網路開發工具, Tensorflow 已將之收錄到自己的套件中, 並命名為 tf.keras。本書同時適用於最新的 tf.keras 及 Keras。?